【演算法破解 Ep.2】AI 實測:Threads 演算法更看重誰?隨機森林模型揭露「讚」的權重竟是轉發的 6 倍!

Threads 演算法破解 Ep.2!相關性不等於因果,我們進階使用「隨機森林」模型,實測 2026 年 1 月最新 10 萬筆數據。AI 分析結果驚人:「讚」的權重高達 65%,竟是「轉發」的 6 倍!內文公開完整特徵重要性數據與 R-squared 模型解釋力,教你用機器學習找出真正的流量權重。

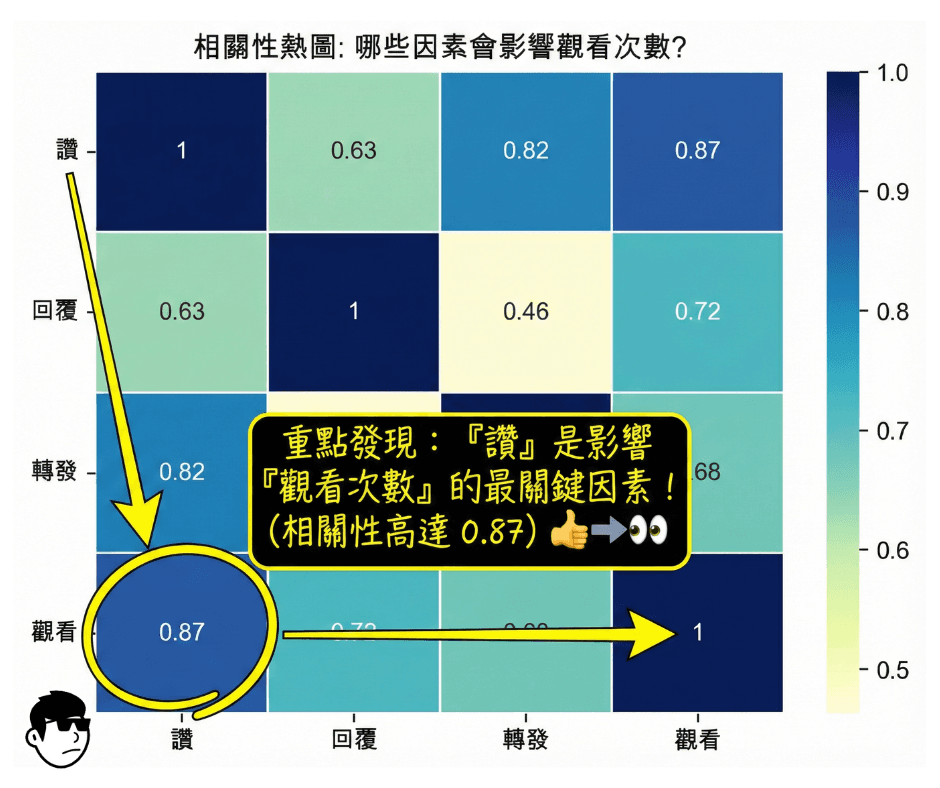

上一集,我們用「熱力圖」證明了「按讚」跟「曝光」的關係最密切。但這時候一定有人會跳出來說:

「相關性又不等於因果!搞不好是因為曝光多,所以讚才變多啊?」

沒錯,統計學的第一課就是「Correlation is not Causation」。光看熱力圖,我們只能看到誰跟誰走得近,卻看不出「演算法大腦」在想什麼。

為了挖出 Threads 演算法內部的「權重分配」,這次我們不只是畫圖,而是直接寫程式訓練一個 AI——使用機器學習中的「隨機森林迴歸模型 」,把那 2026 年 1 月份的 10 萬筆數據丟進去訓練,讓 AI 自己告訴我們:在它眼裡,哪個指標才是真正的老大?

結果非常驚人,數據直接量化了「讚」的統治地位。

為什麼要用「隨機森林」?

隨機森林 (Random Forest) 是一種非常強大的機器學習演算法。

簡單把它想像成「100 個社群專家」同時在開會。我們把 10 萬篇貼文的數據(讚、回覆、轉發)丟給這 100 個專家,讓他們去預測每一篇貼文的「觀看數」。

當訓練完成後,我們就可以反問這些專家:「嘿,你們在預測觀看數時,覺得哪個指標最重要?」

這就是所謂的 特徵重要性。這比單純的相關係數更具備因果解釋力,因為它模擬了決策過程。

Python 實戰:訓練你的 AI 鑑識官

這是核心程式碼,我們使用 scikit-learn 套件來完成這件事:

### 延續上集程式碼

import pandas as pd

from sklearn.ensemble import RandomForestRegressor

from sklearn.model_selection import train_test_split

from sklearn.metrics import r2_score

# 1. 準備數據 (X=特徵, y=目標)

# 這裡我們用 '讚', '回覆', '轉發' 來預測 '觀看'

X = df[['讚', '回覆', '轉發']]

y = df['觀看']

# 2. 切分訓練集與測試集 (80% 訓練, 20% 考驗)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 3. 建立並訓練隨機森林模型

# n_estimators=100 代表我們請了 100 棵樹(專家)來投票

rf = RandomForestRegressor(n_estimators=100, n_jobs=-1, random_state=42)

rf.fit(X_train, y_train)

# 4. 提取「特徵重要性」

importances = pd.DataFrame({

"Feature": X.columns,

"Importance": rf.feature_importances_

}).sort_values(by="Importance", ascending=False)

print("--- 特徵重要性 ---")

print(importances)

# 5. 驗證模型準確度 (R-squared)

# 用保留的那 20% 測試資料來考考模型

y_pred = rf.predict(X_test)

r2 = r2_score(y_test, y_pred)

print(f"\n--- 模型解釋力 (R-squared) ---")

print(f"R-squared score: {r2}")數據解密:AI 眼中的權重分配

程式跑完後,模型吐出了這張成績單:

| 特徵 | 重要性 | 佔比 |

| 讚 | 0.656 | 65.6% |

| 回覆 | 0.228 | 22.8% |

| 轉發 | 0.116 | 11.6% |

這組數字比上一集的熱力圖更殘酷,也更清晰:

「讚」是絕對主宰 (65.6%): 在預測流量時,「讚數」的權重超過了六成。這代表 Threads 的演算法在判斷「這篇貼文該不該給更多人看」時,最重要的訊號就是點讚。

轉發真的沒那麼神 (11.6%): 你沒看錯,雖然轉發能把貼文擴散出去,但在演算法的權重計算裡,它的影響力甚至只有「讚」的 1/6,也只有「回覆」的一半。

回覆是第二把交椅 (22.8%): 留言互動確實有效,它是輔助讚數的重要推手,但不是主力。

還有 47% 的「幽靈因素」?(R-squared 分析)

做數據分析不能只報喜不報憂。我們的模型跑出了一個 R-squared Score = 0.535。

這是什麼意思?

意思是:光靠「讚、回覆、轉發」這三個公開指標,我們只能解釋 Threads 流量變化的 53.5%。

那剩下的 46.5% 跑去哪了?這就是演算法的「黑盒子」部分,可能包含了:

停留時間: 用戶停下來看了多久?(後台數據抓不到)

點擊展開 : 有沒有點開「更多」看全文?

發文時間點: 凌晨發文跟下班時間發文,起跑點就不同。

帳號權重: 你是不是原本就是大 V?

...

結論: 雖然我們無法掌握那 46.5% 的黑盒子,但在我們能掌握的 53.5% 裡,全力拚「讚」是投報率最高的策略。

給小編的戰術指導

看完這兩集的數據實測,戰略已經很明顯了:

放棄「求轉發」的執念

「騙讚」不可恥,且有用

10 萬筆數據集下載

想要驗證我的說法?或是想拿去跑其他的分析?這裡提供這次測試用的完整數據集。

數據規格:

時間: 2026 年 1 月(最新演算法環境)

數量: 100,000 筆中文串文數據

內容:各串文發文後約24小時數據快照

下一集預告:拆解隔壁 X 的演算法,直擊「黑盒子」核心!

這集我們用隨機森林去「逆向工程」Threads 的權重,因為它的演算法是不公開的黑盒子。但你知道嗎?隔壁棚的 X (前 Twitter) 其實非常大方地把它的推薦演算法開源了!

下一集,我們將深入拆解 X For You Feed Algorithm 的官方開源架構,看看這套世界級的推薦系統是如何運作的。

搞懂了 X 的邏輯,或許我們就能舉一反三,更透徹地理解所有社群平台(包括 Threads)背後的「上帝視角」。